La néo-géographie sous l’œil des chercheurs

Catégorie: Cartographie, Données, Environnement, Logiciels, Open Data, Recherche, Reportages

La qualité des données géographiques occupe de nombreuses équipes de recherches de par le monde, rassemblées cet automne à la Grande-Motte lors de l’IPRS Geospatial Week. L’information géographique volontaire (VGI en anglais), base d’une « néo-géographie » devient leur principal sujet de préoccupation.

Selon Lex Comber de l’université de Leeds (Royaume-Uni), « un tiers des thèses en géomatique concerne l’information géographique participative ». C’est dire que le sujet préoccupe le monde académique. Outre que les données ouvertes et contributives telles que OpenStreetMap (OSM) fournissent des terrains d’étude facilement mobilisables, elles posent des problèmes spécifiques, notamment en termes de qualité.

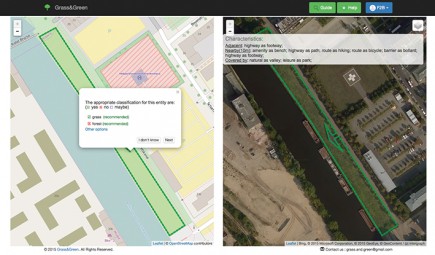

Dans Grass&Green, le contributeur se voit proposer les deux solutions les plus pertinentes pour améliorer la qualification des espaces verts dans OSM.

Des bases complémentaires

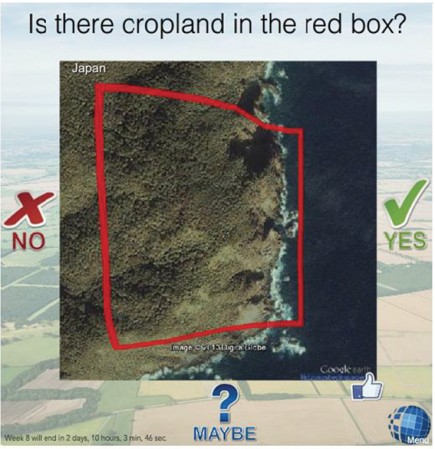

Économique, pléthorique, l’information géographique peut par exemple être utilisée pour améliorer la qualité des productions « officielles ». C’est déjà le cas dans plusieurs instituts géographiques nationaux (voir encadré) mais plusieurs expériences montrent que d’autres mobilisations sont possibles. Ainsi, Gilles Foody de l’université de Nottingham (Royaume-Uni) a fait appel à ses étudiants pour classer différentes photos selon le type d’occupation du sol en Afrique afin de s’en servir comme points de contrôle pour une classification supervisée d’image satellitaire. L’Institut international pour l’analyse des systèmes appliqués (IIASA) propose pour sa part un outil de validation en ligne des classifications en s’appuyant sur Geo-Wiki, baptisé Laco Wiki.

Trouver les bons outils de mesure

À ceux qui en seraient encore à comparer bases « officielles » et « officieuses », les spécialistes de la qualité apportent de nouveaux outils. Tobias Törnros de l’Institut de géographie de l’université d’Heildelberg (Allemagne) a comparé OSM et la base ALKIS (équivalent du cadastre allemand). Dans une étude menée sur plusieurs villes allemandes, il montre que s’appuyer sur un simple comptage des bâtiments sous-estime la complétude d’OSM car les bâtiments à cheval sur deux parcelles sont comptés deux fois dans ALKIS. Inversement, si ce sont les surfaces de bâtiments qui sont prises en compte, OSM va apparaître plus complet qu’il ne l’est en réalité car la simplification de la géométrie augmente la superficie totale de la classe « bâtiments ».

Organiser le contrôle qualité

Le contrôle qualité peut se faire a priori, pendant la saisie ou a posteriori. A priori, les efforts vont porter sur la sélection des contributeurs, leur formation et l’explicitation de ce que l’on attend d’eux. Les chercheurs s’intéressent également à la mise à disposition d’assistants et d’outils de détection d’incohérences afin de faciliter le travail en cours. Enfin, a posteriori, nous retrouvons les « vieilles » catégories d’évaluation de la qualité, mais elles doivent s’appuyer sur de nouveaux indicateurs liés aux spécificités des bases participatives.

Cidàlia Fonté de l’université de Coimbra (Portugal) recense par exemple toutes les bonnes questions à se poser avant de mobiliser des volontaires : quel niveau d’expertise technique est nécessaire, de connaissance locale, quel niveau de détail sera recherché, de quel support bénéficieront les contributeurs (échanges avec des experts, uniquement entre eux), quel degré de redondance est accepté, qui effectue le contrôle qualité (modération entre participants ou par des experts extérieurs)… Mahmoud Reza Delavar de l’université de Téhéran (Iran) propose pour sa part d’analyser les profils sociodémographiques des internautes pour les répartir en groupes et associer ainsi un niveau de confiance à chaque groupe (et non plus aux individus qui le composent).

Pendant la saisie, l’utilisateur peut être guidé afin d’être le plus pertinent possible. C’est tout le sens du dispositif présenté par Didier Leibovici de l’université de Nottingham dans le cadre du projet COBWEB. Les contributeurs sont invités à utiliser une application pour photographier des inondations, en dessiner l’extension en y associant éventuellement des commentaires. Tout un processus de validation des données est proposé. La qualité de la photo prise est automatiquement vérifiée par analyse d’image et l’application demande de se rapprocher si la photo est trop floue. Le profil du participant va permettre de lui associer un coefficient de confiance. Les données saisies seront également validées par comparaison (sémantique, logique et géométrique) avec d’autres bases de données ainsi qu’avec le modèle numérique de terrain. Mais le contributeur peut associer lui-même un degré de confiance aux éléments qu’il saisit, comme l’a testé Gilles Foody avec ses étudiants.

Plusieurs prototypes ont été développés pour organiser le contrôle qualité a posteriori. Et sur ce point, ce sont les problématiques d’occupation du sol qui semblent occuper les chercheurs. Il faut dire que c’est un domaine qui laisse une large place à l’interprétation. Ainsi, Lex Comber a montré que même les données saisies dans Geo-Wiki, pourtant bien encadrées, présentent des différences selon la nationalité des participants.

Grass&Green sert à valider des espaces verts initialement classés sous OSM en prairie, forêt, parc, jardin ou pelouse sur une dizaine de villes allemandes. En exploitant les formes, les entités environnantes (s’il y a un lac au milieu, c’est sans doute un parc…) et à l’aide d’un moteur de règles sophistiqué, l’Internaute n’a plus qu’à choisir entre les deux alternatives de classement les plus probables. Il peut également passer son tour (ne sait pas) ou opter pour une autre catégorie.

Penser la qualité autrement

Faut-il modéliser autrement les éléments de la qualité ? En choisissant Bernadette Bouchon-Meunier, directeur de recherche émérite au laboratoire d’informatique de Paris 6, comme grand témoin, les organisateurs de la conférence ont mis l’accent sur les apports possibles de la logique floue. Même si elle n’est pas neuve, cette approche informatique permet de sortir des visions dichotomiques en introduisant les notions de ressemblance, d’inclusion, de similarité.

« Les cinq grands thèmes de la qualité (complétude, cohérence, précision géométrique, temporelle et thématique) ont été inventés il y a des dizaines d’années par les agences cartographiques nationales pour prouver la qualité des cartes papier qu’elles produisaient. Il faut changer nos cadres de pensée » insiste Viron Antoniou du service géographique militaire de Grèce. Paola Carrara de l’Institut de télédétection pour l’environnement (Italie) propose par exemple de distinguer qualité intrinsèque et extrinsèque. L’intrinsèque se divise à son tour en adéquation (ce jeu de données contient-il les éléments qui me sont nécessaires ?) et précision (comment ont été construites ces données ?), tandis que l’extrinsèque fait référence à la confiance que je peux attribuer aux contributeurs. Il s’agit ensuite de trouver dans les métadonnées les réponses aux trois questions : qui, quoi et comment.

Mais la question n’est finalement pas d’éliminer toutes les erreurs possibles, comme l’a souligné Duccio Rocchini de la fondation Edmund Mach (Italie) à propos GEO BON, un projet collaboratif à l’échelle européenne sur la description de la biodiversité. « Mais elles doivent être explicitées sous forme d’incertitude. Le problème, c’est que les décideurs n’aiment pas l’incertitude ».

| Geo-Wiki |

| Geo-Wiki a été mis en place par (IIASA basé en Autriche) l’université de Fribourg (Allemagne) et l’université de sciences appliquées Wiener Neustadt (Autriche). Il compte aujourd’hui de nombreux soutiens institutionnels et privés. Le portail propose de constituer des bases de données d’usage et d’occupation du sol par photo-interprétation d’images satellitaires sur le globe Google. Différents thèmes, différentes interfaces, des applications mobiles, des jeux, des concours sont proposés pour animer la communauté. De par son ampleur internationale et ses thèmes, Geo-Wiki est un objet de choix pour tous ceux qui s’interrogent sur les bases de données participatives. |

| Les agences s’y mettent |

| Les agences cartographiques nationales sont de plus en plus nombreuses à faire appel à l’information géographique participative. Une étude menée dans le cadre du programme de recherche COST a montré que 13 agences européennes sur les 26 interrogées utilisaient désormais ce type de données, principalement pour détecter des changements ou des erreurs. Dix ont mis en place leur propre système de collecte (comme RIPart à l’IGN), tandis que trois utilisent des données OSM ou GeoNames. Le cadastre hollandais a ainsi testé une application en ligne de signalement sur ses bases de données topographiques, qui sont désormais en libre accès (licence CC-BY). Le prototype, réalisé sous ArcGIS, a permis de recueillir les contributions de 130 clients en deux mois, issus à 70 % du secteur privé. Seuls 10 % des signalements se sont avérés faux. Désormais, une nouvelle version plus industrielle est en ligne. Sa gestion occupe une personne à plein-temps et va permettre de proposer une mise à jour tous les trois mois et non plus tous les deux ans. |

- De nombreux sujets ont été abordés pendant l’ISPRS Geospatial Week : qualité, photogrammétrie, 3D, laser pour la foresterie, drones, hyperspectral, big data géographique, risques majeurs, modélisation urbaine, processus cognitifs… Pour accéder directement à l’ensemble des présentations (en anglais), suivez ce lien

Communiqués

Communiqués