Vers un nouveau genre de « deepfake » en cartographie ?

Catégorie: Cartographie, Décalagéo, Données, Imagerie, Recherche

Même si cartes et bases de données comportent régulièrement des erreurs volontaires, il est maintenant possible de modifier en profondeur des images satellites. Comment réagir ?

Même si cartes et bases de données comportent régulièrement des erreurs volontaires, il est maintenant possible de modifier en profondeur des images satellites. Comment réagir ?

Les erreurs volontaires existent depuis la naissance de la cartographie. La manipulation de certains petits détails lors de la rédaction des cartes, puis lors de la création des bases de données reste l’un des moyens les plus simples de se protéger contre les plagiats et autres copies illégales. Les cartographes sont également connus pour aimer glisser des « petits fantômes » dans leurs créations : un point sur sa maison, un toponyme inventé dérivé du nom d’un ami ou d’un mot à placer à la suite d’un pari perdu… des pratiques qui rappellent que derrière chaque carte, il y a un auteur, et qui adressent un signe amical aux lecteurs capables de les identifier, en mode « c’est moi qui l’ai fait ». Mais des étudiants de géographie de l’université de Washington ont mené une étude d’un nouveau genre, montrant comment les techniques d’intelligence artificielle peuvent être utilisées pour générer de fausses images satellitaires d’une ville américaine. Ils ont ainsi appliqué la « texture urbaine » de Pékin et de Seattle (analysée par deep learning) sur un quartier de Tacoma dont ils ont conservé la géométrie. À vue d’œil, sans légende ni analyse des histogrammes, impossible de dire quelle est la véritable image satellitaire.

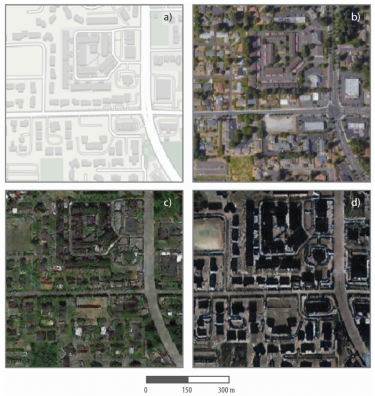

En haut à gauche, le fond cartographique du quartier de Tacoma analysé par Bo Zhao et ses collègues. À droite, la véritable image satellite. En bas à gauche, façon Seattle (beaucoup de jardins) et en bas à droite, façon Pékin (immeubles hauts)

L’exercice est modeste et un peu théorique mais il a le mérite de mettre en lumière un danger qui risque fort de peser sur les analyses spatiales dans les prochaines années : comment s’assurer de la fiabilité des données géographiques qui entrent dans divers processus décisionnels ou de connaissance ? Nous observons de plus en plus le monde à travers le prisme des données, et les images satellites nous semblent être des bases d’informations irréfutables et objectives par nature, puisqu’elles proviennent de capteurs éloignés et sans risque de pollution par les humains. Même s’il n’en est rien (derrière chaque image, même satellitaire, il y a des choix signifiants), les fournisseurs et transformateurs de données doivent désormais garantir qu’aucune intelligence, ni humaine, ni artificielle, n’a pu s’intercaler entre le capteur et l’image qu’il produit, alors même que de nombreux traitements automatiques sont déjà nécessaires pour transformer une télémétrie en image exploitable. Demain, comment « labelliser » des images alors que leur circulation n’a jamais été aussi rapide ? Faudra-t-il mobiliser une autre technique comme la blockchain ? La question commence à peine à se poser…

Communiqués

Communiqués